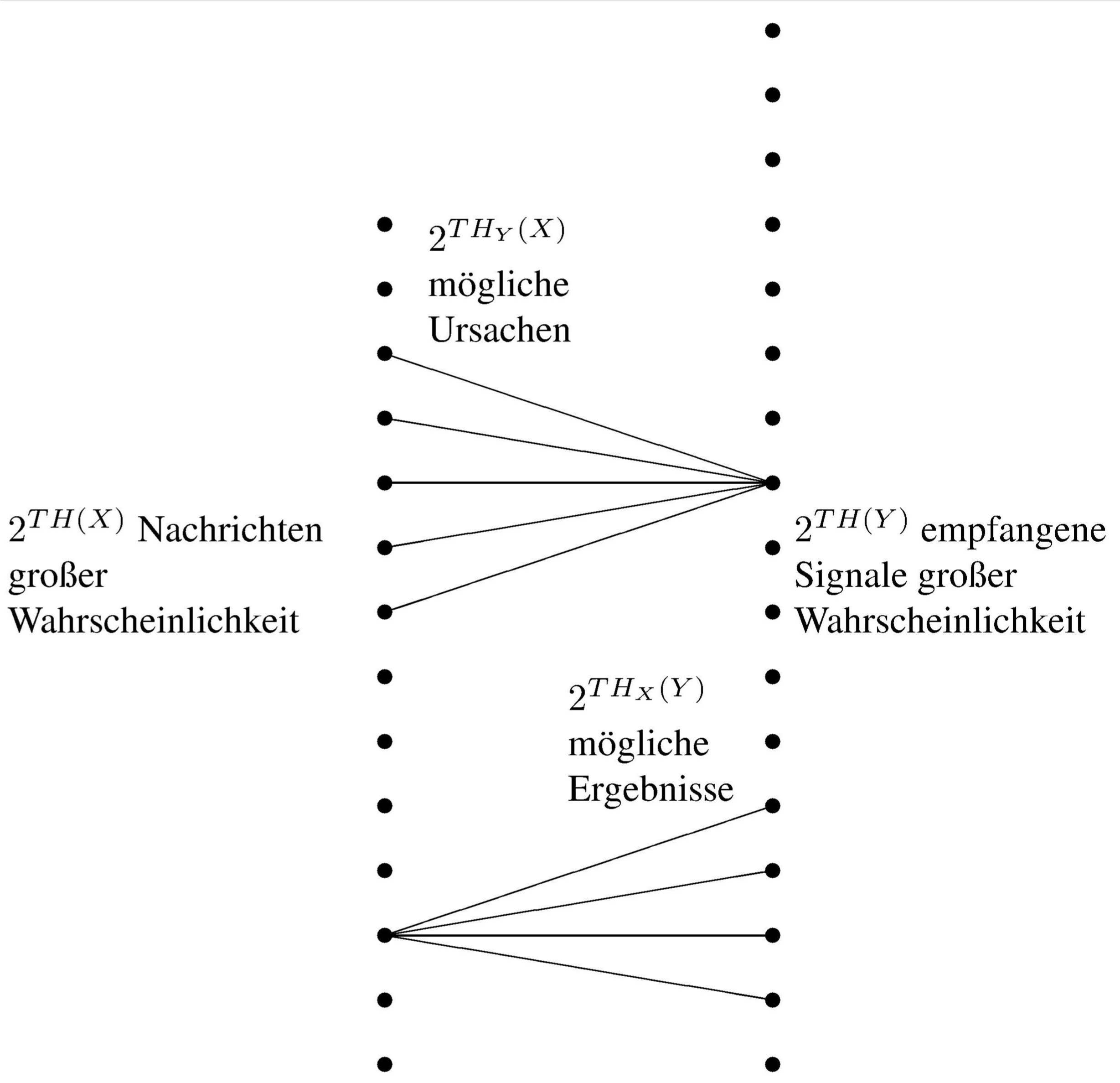

links: Sender, rechts: Empfänger

Ein diskreter Kanal habe die Kapazität C und eine diskrete Quelle die Entropie H pro Zeichen. Dann gilt nach Shannon (1948)

Für H < C gibt es eine Kodierung, die die Quellinformation mit beliebig kleiner Fehlerwahrscheinlichkeit, d. h. mit beliebig kleiner Äquivokation, überträgt.Shannon selber hat 1948 den Beweis in der Weise skizziert, daß er nicht eine derartige Kodierungsmethode angibt, sondern zeigt, daß es eine solche Kodierung innerhalb einer gewissen Gruppe von Kodierungen geben muß. Wenn im Mittel über diese Gruppe die Äquivokation kleiner als ein vorgegebener Wert ε ist, dann muß es mindestens ein Mitglied mit einer Äquivokation kleiner als ε geben.

Für H ≥ C kann durch Wahl der Kodierung die Äquivokation kleiner als H − C + ε, jedoch nicht kleiner als H − C gemacht werden.

Wir betrachten also eine Quelle S0 der Entropie H(X), deren Zeichenwahrscheinlichkeiten die Kanalkapazität möglichst erreicht und verwenden aus ihr Zeichenketten einer großen Länge T als Eingangssignale für den Kanal. Diese Ketten gliedern sich (siehe Quellenkodierung) in zwei Gruppen: eine hochwahrscheinliche Gruppe mit ungefähr 2TH(X) Mitgliedern und die verbleibenden Ketten mit sehr kleiner Gesamtwahrscheinlichkeit. Faßt man auf der Empfängerseite die möglichen Zeichen ebenfalls in dieser Länge zusammen, so bestehen sie aus einer hochwahrscheinlichen Gruppe von 2TH(Y) Mitgliedern und den übrigen mit sehr geringer Gesamtwahrscheinlichkeit.

Die Zeichen dieser Quelle werden nicht fehlerfrei übertragen, denn jede empfangene Zeichenkette aus der hochwahrscheinlichen Gruppe kann wie in der folgenden Abbildung dargestellt wegen der störungsbedingten Äquivokation HY(X) von mehr als einer, nämlich von 2THY(X) Eingangsketten erzeugt worden sein.

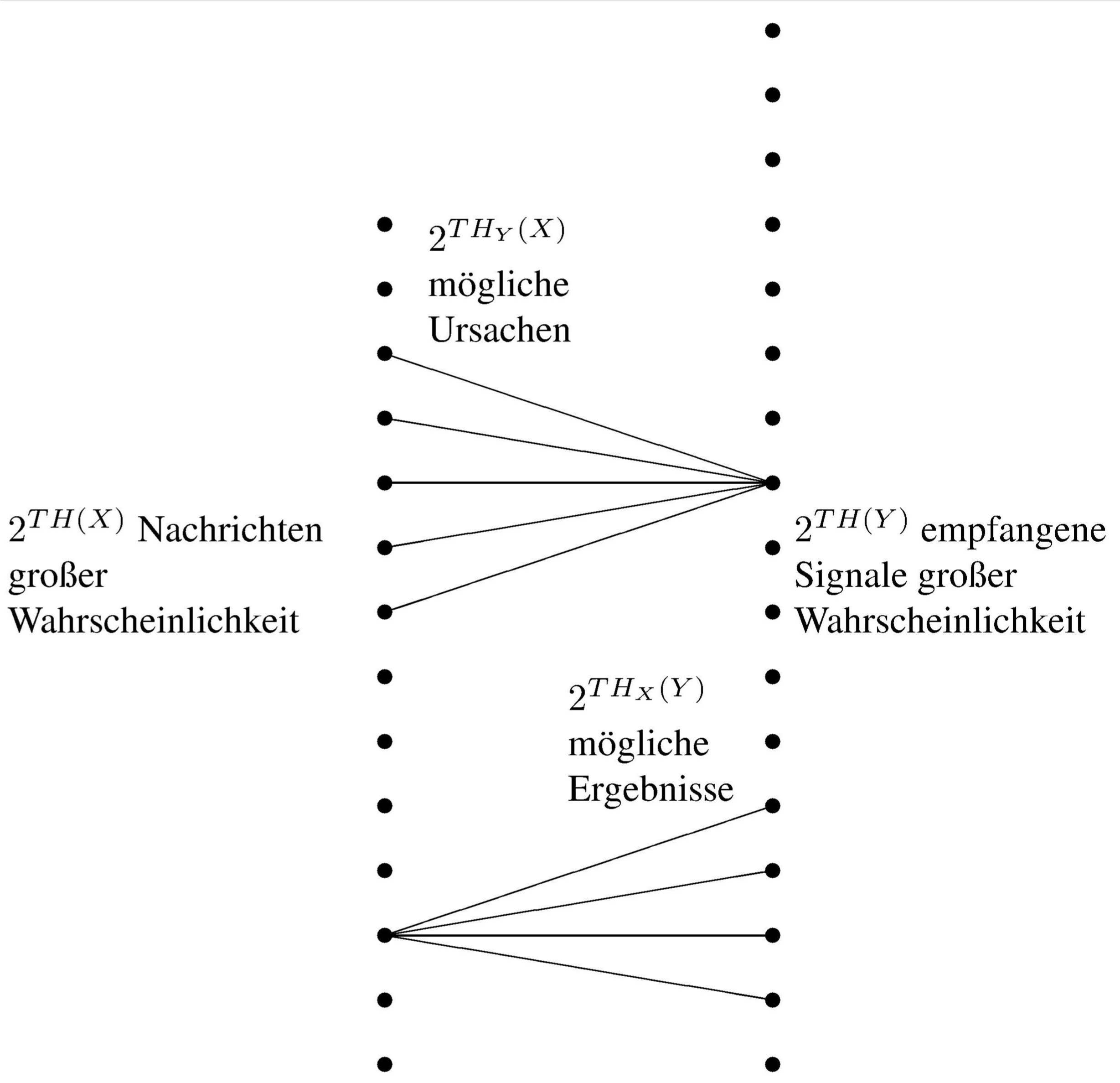

Betrachten wir jetzt aber eine andere Quelle, die pro Zeichen im Mittel nur die Information R < C in den Kanal einspeist und für die der erste Teil des Satzes also gelten soll. Hier gibt es 2TR hochwahrscheinliche Eingangsketten der Länge T. Diese ordnen wir auf alle möglichen Weisen unter ausschließlicher Verwendung der hochwahrscheinlichen Ketten der Quelle S0 einer Auswahl der 2TH(X) möglichen Eingangsketten zu, d. h. wir kodieren die Eingangsketten auf alle möglichen Arten. Über diese gesamte Klasse von Kodierungen soll die Fehlerwahrscheinlichkeit gemittelt werden. Zum Zweck dieser Mittelung können wir also annehmen, daß die zu übertragenden Nachrichten diesen Zeichenketten der Länge T völlig zufällig zugeordnet sind.

Wenn nun eine spezielle Kette am Ausgang empfangen wurde, wie groß ist dann die Fehlerwahrscheinlichkeit, d. h. die Wahrscheinlichkeit, daß mehr als eine Eingangskette sie verursacht haben kann? Es sind 2TR Nachrichten zufallsgemäß auf 2TH(X) Punkte in der obigen Abbildung verteilt. Die Wahrscheinlichkeit PN, daß ein bestimmter Punkt eine Nachricht ist, ist daher

Zum Beweis der zweiten Hälfte nehmen wir an, daß wir im Mittel von der Quellinformation H(X) nur einen beliebigen Anteil der Größe C senden, was wegen des ersten Teils des Satzes mit beliebig kleiner Äquivokation möglich ist. Zu diesem beliebig kleinen Äquivokationsbeitrag kommt dann auf der Empfängerseite wegen des weggelassenen Teils die Äquivokation HY(X) = H(X) − C hinzu.

Der Kanalkodierungssatz zeigt, was man bei vorgegebenen Störungen durch eine geeignete Kodierung erreichen kann, nämlich:

Daß wir den Kanalkodierungssatz hier nur für diskrete Kanäle betrachtet haben, bedeutet insofern keine wesentliche Einschränkung, als reale kontinuierliche Kanäle wegen beschränkter Amplitudenauflösung diskretisiert betrachet werden können. Tatsächlich wird in der Praxis hiervon durch Analog-Digital-Wandlung zunehmend auch technisch Gebrauch gemacht.

© Günter Green

zurück

weiter

zurück zum Anfang

22-Sep-2018